OFFRES FREELANCE

Amazon fait une offre de rachat de TikTok

(AFP) – Amazon a soumis une offre de rachat de l’intégralité de TikTok au gouvernement de Donald Trump, qui cherche une issue favorable au dossier à l’approche d’une échéance décisive,…

Transavia France ouvre 20 postes IT alors que la compagnie…

Transavia, la filiale low-cost du groupe Air France KLM, accélère ses projets IT pour accompagner sa croissance. La compagnie annonce l’ouverture de 20 nouveaux postes au sein de ses équipes…

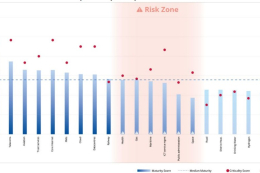

Cybersécurité : 6 secteurs dans “la zone de risque” en…

L’ENISA, agence européenne pour la cybersécurité, alerte dans son premier rapport NIS 360 sur six secteurs qui se “situent dans la zone de risque”. Plusieurs secteurs doivent “améliorer leur maturité…

Une étude alerte sur les cyberattaques subies par les opérateurs…

Semperis révèle dans une étude publiée aujourd’hui que 62 % des opérateurs d’eau et d’électricité interrogés ont subi une cyberattaque au cours des 12 derniers mois. Et une grande majorité…

AVIS D’EXPERT – Cryptographie post-quantique : anticiper cette révolution technologique…

Le monde numérique est à l’aube d’une révolution technologique avec l’arrivée de l’informatique quantique. Si cette technologie promet des avancées spectaculaires dans des domaines comme la modélisation moléculaire, l’intelligence artificielle…

Un véhicule assisté par IA provoque un accident mortel

L’accident, relaté par Bloomberg, se serait produit sur une autoroute de la province chinoise de l’Anhui le 29 mars dernier. Un véhicule électrique Xiaomi SU7, équipé d’un système d’assistance à…

SUIVRE TOUTE L'ACTUALITÉ

Transavia France ouvre 20 postes IT alors que la compagnie développe un ensemble de projets structurants

Transavia, la filiale low-cost du groupe Air France KLM, accélère ses projets IT pour accompagner sa croissance. La compagnie annonce l’ouverture de 20 nouveaux postes au sein de ses équipes IT pour l’année 2025. Transavia France développe un ensemble de projets IT structurants pour améliorer…