- Les plateformes de stockage prêtes à croiser les données

- ibm-siege-belgique

- trophees

- rideau-fer-1

- logo-amazon-1

Agiles et évolutives, elles s’adaptent aux stratégies Big Data et aux déploiements vers le Cloud. Les plateformes de stockage multiplient les CPU et les disques SSD pour croiser et analyser davantage de données, et se re-configurer en quelques minutes.

Les fournisseurs reformulent leurs plateformes de gestion de données numériques pour rendre accessibles aux équipes de l’entreprise toutes les informations dont elles ont besoin, au meilleur coût. « Les deux grandes problématiques qui gravitent autour de la data sont la gestion de capacité, en forte croissance, et les besoins de performances. Le disque dur, dernier média aux composants mécaniques, formait le point de contention du stockage. A présent, nous enregistrons une croissance à trois chiffres sur nos unités Flash issues de la technologie NAND », dépeint Jean-François Marie, directeur des solutions et alliances NetApp sur la zone EMEA. Vu de sa fenêtre, le rafraichîssement de la gamme SAN haute densité (NetApp AFF modèles 700 et 700S) déplace le point d’engorgement au niveau des applications et du réseau étendu. En pratique, les performances délivrées atteignent un temps de réponse moyen de 0,69 ms en Flash, sur disque ou dans le Cloud, un nuage hybride vers lequel de plus en plus d’entreprises se tournent. Selon la charge applicative, la compression des données fournit un rapport allant jusqu’à 5:1, soit 1 Peta-octet sur 24 disques de 15,3 To. La réduction des coûts provient à la fois d’une moindre énergie consommée et d’une empreinte physique réduite dans le datacenter.

Des architectures à très haute densité

Pour offrir plus de disponibilité aux utilisateurs, les sous-ensembles des baies de stockage sont redondés, deux à trois fois maintenant. Leur densité croissante permet également de servir plusieurs usages simultanément : gestion de contenus web en mode fichiers, accès aux bases de données en mode blocs, et partages de grands volumes non structurés, en mode objets. Des applications mainframe jusqu’aux charges virtualisées, plus rien ne doit leur échapper, pas même les micro-services. Du coup, les leaders Dell Technologies, IBM, HPE, NetApp et HDS multiplient les traitements en temps réel au cœur du stockage.

Hitachi Data Systems

« La tendance est à la généralisation de l’architecture Intel mais, pour des raisons de performances ou de sécurité, on fait appel aussi aux accélérateurs matériels (GPU, FPGA). Ces modules apportent des traitements de données à la volée ou facilitent le déploiement d’outils IA tel le Deep Learning, signale Vincent Franceschini, Chief Research Officer d’Hitachi Data Systems. L’apprentissage automatique est une tendance intéressante, que ce soit pour améliorer la compréhension des données stockées et/ou pour optimiser le placement de celles-ci vers les supports adaptés ».

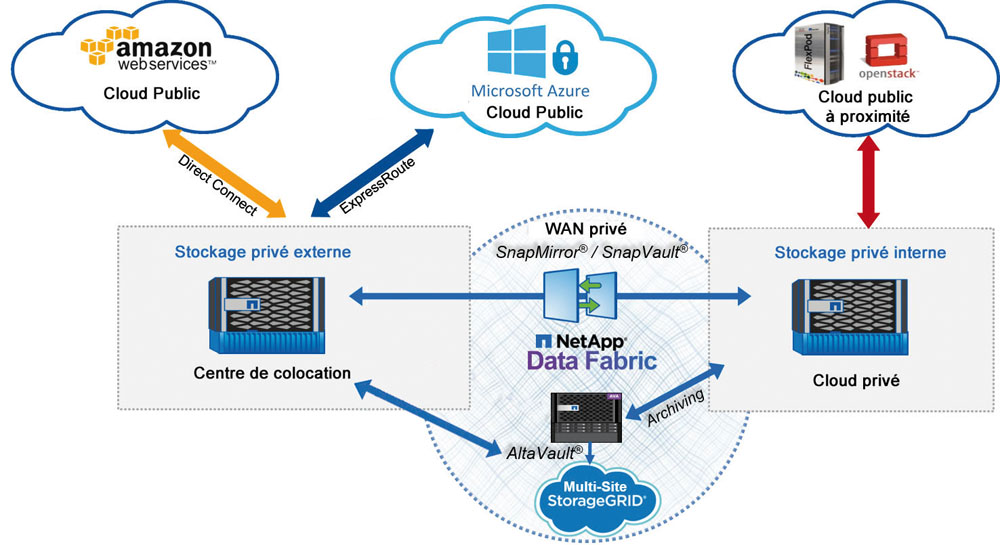

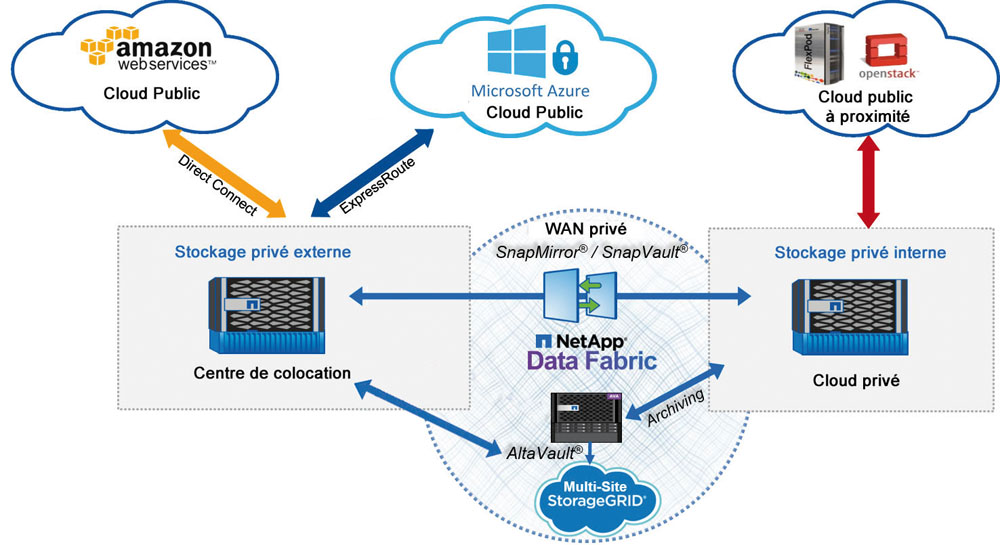

Les acquéreurs de baies Infinidat exercent surtout dans les secteurs de la finance, de la santé, de l’énergie ou des médias. « Nos clients privilégient la flexibilité, la fiabilité, la sécurité de manipulation et un faible coût de possession du stockage », note François Morel, le directeur de la filiale française. L’InfiniBox (100 To à 5,7 Po) s’inscrit dans la tendance SDS (Software defined Storage), une approche répandue chez les challengers du marché et chez les éditeurs de logiciels de virtualisation du stockage. Elle se distingue par sa gestion analytique qui tente d’offrir le meilleur positionnement possible des données, regroupées par blocs de 64 Ko avec empreinte (checksum) sur les médias internes, à savoir 3 To de cache, 200 To de SSD et jusqu’à 480 disques SAS de 4 ou 8 Go. Vendue au fil des volumes consommés (pay as you grow), cette baie 42 U contient des serveurs Dell multi-cœurs, délivre de 115 To à 5 Po avec plus d’un million d’IOPS et un débit supérieur à 12 Go/sec pour 130 à 180 µs de délai de latence seulement. Sa consommation d’énergie ne dépasse pas 8 KW, soit 3,5 W par To. En intégrant des processeurs Intel multi-cœurs, des interfaces réseaux haut débit et un moteur de virtualisation, la plateforme hyperconvergée (Nutanix ou Simplivity) procure une alternative tout-en-un à la baie de disques externe. « C’est une formule matérielle condensée, simple à implémenter mais complexe à exploiter. Si un nœud devient obsolète, peut-on le remplacer à chaud ? Peut-on ajouter de la puissance CPU ou de la capacité indépendamment ? Pour qu’un traitement aille vite, la donnée doit être placée au plus près du processeur », recommande Jean-François Marie. D’après lui, cette plateforme répond surtout à un cycle d’évolution pour consolider des clusters : elle va régler la problématique des PME mono-applications. Mais l’entreprise confrontée à l’explosion des volumes de données devra se tourner, tôt ou tard, vers une plateforme offrant plus de libertés d’évolution. Justement, la Data Fabric de NetApp propose un contrôle du Cloud hybride, en connectant le stockage primaire aux nuages d’Amazon ou de Microsoft, et en proposant des mécanismes communs de reconstruction de disques, en cas de panne.

Des traitements analytiques embarqués

Avec leurs protections natives, leurs accélérateurs matériels et leurs réplications dans le Cloud, les dernières baies de stockage cherchent à répondre aux pics d’activité des utilisateurs, donc aux montées en charge applicatives. Elles se déclinent en solutions pouvant évoluer verticalement (scale-up) par adjonction de disques ou horizontalement (scale-out) par ajout de nœuds complets. « La déduplication, la compression et le chiffrement des données sont des fonctionnalités confiées aux équipements de stockage dorénavant. On peut anticiper les prochaines capacités de processing pour examiner les contenus et faire de l’analyse avec des objectifs d’optimisation des performances ou de mise à disposition d’informations », prévoit déjà Vincent Franceschini. La plateforme de gestion de données cherche à préparer l’environnement idéal, pour intégrer, explorer, analyser plusieurs flux au travers de traitements successifs. Elle tente de rapprocher de nouveaux états statistiques et graphiques prévisionnels des outils de travail collaboratifs et des procédures en place dans le datacenter, voire dans d’autres services de l’entreprise. Du coup, les salariés vont être guidés pour prendre de meilleures décisions. Par exemple, ils vont pouvoir créer de nouvelles offres personnalisées pour améliorer la satisfaction des clients les plus importants.