[ Juridique ]

Avis de recherche : où est passée la Directive…

OFFRES FREELANCE

Master Dev France 9e édition : quelles nouveautés ?

Docaposte, filiale numérique de La Poste, organise le mercredi 12 mars 2025 son événement Master Dev France, qui s’est donné cette année pour thématique de réflexion « L’avenir de l’IA,…

IA : les 500 milliards de dollars de chiffre d’affaires…

D’après les prévisions publiées par les Market Insights de Statista, le secteur mondial de l’IA pourrait dépasser les 500 milliards de dollars de chiffre d’affaires d’ici 2028. Apprentissage automatique, robotique…

Etude – IA : son adoption à grande échelle reste…

L’Intelligence Artificielle est sur toutes les lèvres, mais son adoption à grande échelle reste un défi pour de nombreuses entreprises. La raison selon un rapport de Kyndryl ? Un manque…

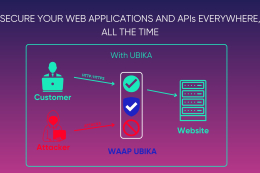

AVIS D’EXPERT – Concilier collaboration, innovation et sécurité face aux…

À l’heure où les environnements de travail numériques transforment radicalement nos manières de collaborer, les DSI se trouvent au carrefour de l’innovation et de la vigilance. L’essor des digital workplaces,…

ExpressVPN réécrit son protocole Lightway en Rust

Rust est vu comme un langage plus sécurité que le C ou le C++, particulièrement sur la gestion mémoire. ExpressVPN annonce une refonte complète de son protocole VPN, Lightway. L’éditeur…

Cybersécurité et quantique : 3 mesures pour ne pas être…

Le post-quantique est aujourd’hui l’un des sujets importants des spécialistes en sécurité. Keyfactor, spécialiste des solutions de sécurisation des identités digitales, met en avant 3 mesures pour ne pas être…

SUIVRE TOUTE L'ACTUALITÉ

IA : les 500 milliards de dollars de chiffre d'affaires estimé d'ici 2028 profiteront d'abord à l'apprentissage automatique

D’après les prévisions publiées par les Market Insights de Statista, le secteur mondial de l’IA pourrait dépasser les 500 milliards de dollars de chiffre d’affaires d’ici 2028. Apprentissage automatique, robotique basée sur l’IA et traitement automatique des langues sont les trois segments à la plus…