[ Chiffrement ]

“Ne prenez jamais pour acquis les promesses des…

OFFRES FREELANCE

« Notre ambition, c’est d’avoir la solution souveraine de sécurisation des…

Sur son stand au FIC, Stéphane Bouché, président de Secuserve, nous présente les dernières nouveautés de sa société, notamment sur les sujets de la réglementation et du DMARC. SNC…

« L’idée, avant de parler cyber, c’est de parler culture générale…

A l’occasion du FIC, Solutions Numériques & Cybersécurité a eu la chance de rencontrer Hadi El-Khoury dans la foulée de la conférence de presse de Lumérique, une nouvelle initiative pour…

Amazon fait une offre de rachat de TikTok

(AFP) – Amazon a soumis une offre de rachat de l’intégralité de TikTok au gouvernement de Donald Trump, qui cherche une issue favorable au dossier à l’approche d’une échéance décisive,…

Transavia France ouvre 20 postes IT alors que la compagnie…

Transavia, la filiale low-cost du groupe Air France KLM, accélère ses projets IT pour accompagner sa croissance. La compagnie annonce l’ouverture de 20 nouveaux postes au sein de ses équipes…

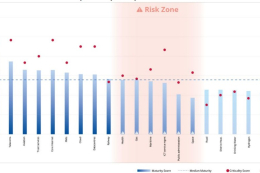

Cybersécurité : 6 secteurs dans “la zone de risque” en…

L’ENISA, agence européenne pour la cybersécurité, alerte dans son premier rapport NIS 360 sur six secteurs qui se “situent dans la zone de risque”. Plusieurs secteurs doivent “améliorer leur maturité…

Une étude alerte sur les cyberattaques subies par les opérateurs…

Semperis révèle dans une étude publiée aujourd’hui que 62 % des opérateurs d’eau et d’électricité interrogés ont subi une cyberattaque au cours des 12 derniers mois. Et une grande majorité…

SUIVRE TOUTE L'ACTUALITÉ

« L'idée, avant de parler cyber, c’est de parler culture générale numérique » Hadi El-Khoury, codirigeant de Lumérique

A l’occasion du FIC, Solutions Numériques & Cybersécurité a eu la chance de rencontrer Hadi El-Khoury dans la foulée de la conférence de presse de Lumérique, une nouvelle initiative pour la sensibilisation des jeunes à l’hygiène numérique. SNC – Qu’est-ce que Lumérique ? Hadi El-Khoury –…